今ゲーム開発をしているのですが,キャラクターのアニメーションを描くのが面倒なので画像生成AIを使ってなんとかできないかなぁと思って試してみました.実写動画か落書きアニメーションからアニメーションの連番画像を生成するのが目標です.

基本構成

- Stable Diffusion web UI:画像生成AIをブラウザで操作できるツール(実行はローカル環境)

- Anything-V4.5:画像生成モデルの一つ.

- animeoutlineV4:線画に特化したLoRA(追加学習モデルみたいなやつ).

- ControlNet:ポーズ指定や落書きからの画像生成などいろいろできる便利なモデル.今回は輪郭を抽出するCannyを使う.

下準備

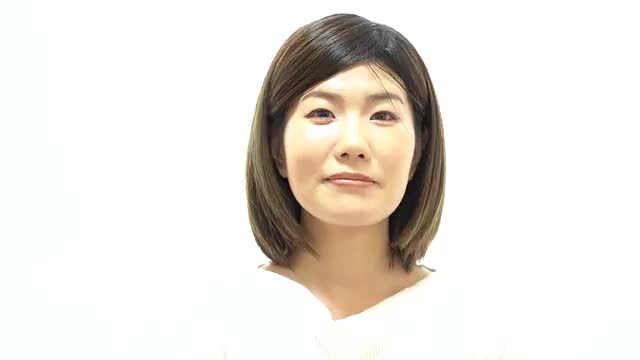

手元に適当な動画が無かったので,フリー素材を探してダウンロード.今回は女性がグッドサインをするシンプルな動画を使用.

これをffmepgという動画編集プログラムで連番画像に書き出し.300枚ぐらいの連番画像が出力されるが,今回はテストなので適当に以下の5枚をチョイス.

生成

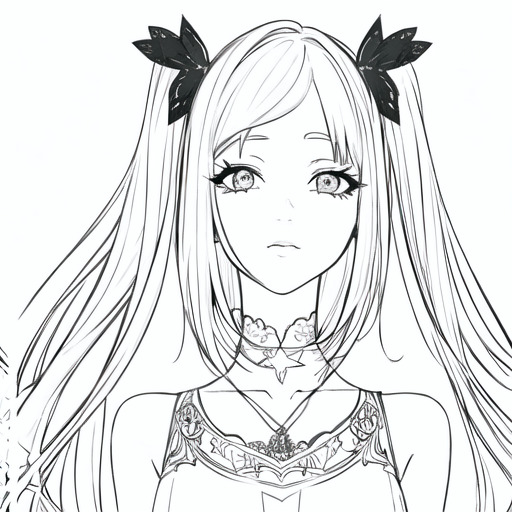

あとはプロンプトとパラメータを適当に(masterpiece, best quality, 1girl, lineart, monochrome, white background, <lora:animeoutlineV4_16:1>)入力し,ControlNetに元の画像を入れて新しい画像を生成するだけだが,それぞれ単体で生成してしまうと絵柄のブレが出てしまうので以下のスクリプトを追加する.連番画像をグリッドで並べて生成することで,画像間のブレを少なくすることができるようだ.

試しに生成してみたのが以下.サンプル数が少なすぎてうまくいっているのあわからないが,まあアニメーションといえなくもない気がする.プロンプトやオプションをちゃんと設定すれば,もっとうまくいきそうだ.色々試してみよう.

コメント